网站需要的文章页面数量,往往不是数以万计,而是百万级别的,如何短期内让网站收录翻倍或者翻数倍?第一种方法是增加内容,第二种方法 是提升网站在搜索引擎里的“收录率”。

一、增加内容

如何快速增加网站内容?

常见的办法有三种:关键词词库建设、Tag页面生成、UGC页面生成。

二、关键词词库建设

一般在规划网站的时候,是根据产品的sku来生成页面。关键词词库的做法,是挖掘行业内所有的通用词、产品词、竞品词和品牌词,再根据 这些词来生成页面。以58同城为例,建网之初就把地域细化到县城,根据乘法原理:县级单位x通用词X小领域分类x大领域分类生成页面;大众点评则把地域细化到某条马路或者某个POL这样根据乘法原理,过亿的马路就能产生数百亿的页面。

淘宝的关键词词库数以亿计,做返利平台的项目的关键词词库却数以十亿计。

挖词这个工作,对于“资深SEO分析师”来说并不难,难的是如何“打标签”,使得生成的聚合页面不被搜索引擎视为“垃圾页面”,确保页面的原创度和用户体验。

三、Tag页面生成

关键词词库建设,是以关键词为核心,迅速生成亿万级别的页面,那么,Tag聚合页面,是以关键词指数为核心,迅速生成千万级别的Tag页面。

Tag页面可以理解成专题、列表页,但对于Tag页面的权重,从投票的原理讲,Tag页面有多个内页进行投票,权重应该高于文章页,这也是几乎所有门户网站都做过的事情;从用户体验的角度考虑,Tag页面有时候远不如文章页更有参考价值。前不久百度打击网站垃圾页面,其中,备受打击的主要是Tag页面。

很多门户类网站,先是批量釆集垃圾页面,甚至不会去重,直接堆积在网站数据库,然后根据关键词生成Tag页面。虽然文章对于搜索引擎来说是垃圾,但文章title或meta生成的Tag页面对于搜索引擎来说就是原创。虽然搜索引擎对Tag页面的权重越来越低,但相关度高、用户体验好的Tag页面,仍然具有很高的投票能力。

Tag页面生成的第一步是拓词,方式与关键词词库建设一样。区别在于,需要制作不同的专题模板,而且首页必须给一个入口。

以某保险类网站为例,先做一个标签页,即入口页。

1、Tag关键词聚合页后台需求建议

(1)支持关键词去重功能,当某个关键词在导入到后台关键词库中后,再次导入关键词无效,即新导入的重复关键词不生成ID,也不生成新的页面。

(2)每次能够批量导入1-5000个关键词,并给导入的每个新的不重复的关键词生成单独的ID

(3)在后台会提示哪些导入的关键词是重复的,并支持删除重复关键词的功能。

(4)后台导入关键词后,点击生成页面,能够在后台预览到网站数据库中生成的页面信息。

(5)后台能够检测到不同的关键词生成结果页时的内容重复度,若多个关键词之间的内容出现了70%以上的重复,则后台会有对应的提示,且这些出现重复ID的关键词不生成页面和URL。

(6)后台需要设置超级管理员和普通用户的用户权限级别,普通用户可以上传关键词和预览生成页面、查询关键词ID信息功能,但没有发布上线关 键词页面的权限;超级管理员除了拥有普通用户的所有权限外,还有点击发布上线搜索关键词的权限。

(7)导入的关键词必须包含两个中文字符或两个英文字符才有资格生成搜索聚合页,单个汉字或英文字母不支持导入到关键词库和生成页面的资格。

(8)支持给关键词生成的聚合页自动或手动添加Tag标签,这些标签是为 后期调用含有相同标签的资讯文章、评论、专题、其他聚合页使用。

(9)支持对关键词聚合页面的单个和批量的“增、删、改”功能。

(10)支持导出现有搜索聚合页关键词库中的全部或部分关键词功能。

注:如果你的网站CMS没有这些功能,也没事,可以根据这种思路自己调整优化,也可以查看我们锦绣大地SEO培训基地VIP课程,学习使用。

2、Tag聚合页生成注意事项

(1)每个页面最多生成40篇文章,最少生成10篇文章;低于10篇文章的不生成URL和页面°

(2)每个生成的关键词聚合页之间的内容重复度不能高于70%,高于70%的则后来导入的关键词不生成URL和页面。

(3)每个关键词生成的文章标题中必须完整包含一个以上相同词根(词根字符数大于或等于2,若数据库中有中文和英文分词词根最好),此时也需要程序员在关键词导入后,检测生成的文章结果质量。

(4)前期生成的关键词聚合页,必须有专门的人预览检查文章结果的匹配度;若生成的结果不够精准,用户体验不佳,就容易造成垃圾页面,导致被搜索引擎降权。

(5)搜索关键词聚合页面要求代码最精简化,不放置其他频道或活动的广告、JS控件、交互控件、框架内容,不放置超过两个以上的转化和监控代码,一切以追求最高的打开速度和用户体验为准则。

接下来必须符合关键词聚合页规则,如页面聚合规则、标签规则、页面内容板块对应逻辑规则、头部导航、面包屑、资讯页面规则、相关专题规则、URL规则、title规则、meta规则等。关于规则的内容,锦绣大地SEO培训基地有详细的视频介绍。

四、提升网站收录率

虽然我们千方百计地想产生高质量的原创内容,但如果搜索引擎不收录,那么一切都是无用功。因为只有被搜索引擎收录的页面,才对网站具有投票的能力,所以,从这个角度来讲,大型网站的SE0策略的核心其实是在做“收录”,一切的工作都围绕收录产生。

与收录有关的SEO因素,从重到轻有URL、入口、代码优化、外链、服务器优化等。

五、URL优化

URL优化包括很多,重要的大约有10项,根据重要性从高到低依次如下。

•死循环:体现在列表页A点击到B,再从B点击到A,结果发现第二次点击回来的A与第一次点击的A的URL完全不同了。这是收录的大忌,因为蜘蛛一旦进入死循环,就永远陷入其中,爬不出来。

•死链接:假想一下,蜘蛛从网页A爬到网页B再到网页C,结果B打不开,那么C自然就无法收录。还有一种情况是,正文已经删除但URL还在,这类页面可称为“活死链接”,用户体验很烂,建议批量301。

•重复页面:内容一模一样,URL不同。

如4个首页问题,www.cjzzc.com、cjzzc.com、www.cjzzc.com/index.html、cjzzc.com/index.html, 4个URL指向同一个页面;

URL命名规则里的大小写问题,如 www.cjzzc.com/tools.html和www.cjzzc.com/TOOLS.html指向同一个页面,须知在搜索引擎看来,大小写表示两个完全不同的网页;

目录问题,如 www.cjzzc.com/baidu 和 www.cjzzc.com/baidu/ 是两个不同的页面;翻页问题,很多网站做列表页时,翻页的URL基本上不变,被蜘蛛默认为同一页面。

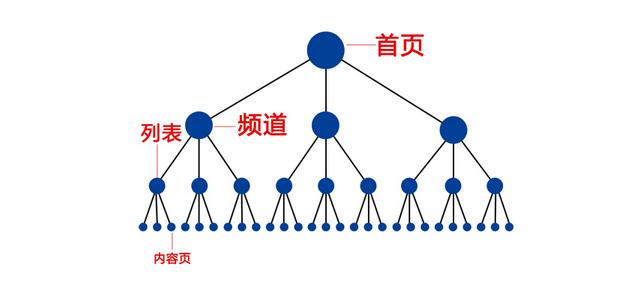

•层级:在建站时,喜欢根据严密的逻辑:“主页-大分类主页-频道首页-产品词首页-专题页-文章页\”,一般能做出6层以上, 搜索引擎会根据每一个网站的权重、更新情况给予蜘蛛爬行时间和次数,如果层级太多,很可能蜘蛛在爬到第五层级时,根本爬不到第六层级,而第六层级往往有大量的“干货”页面。

所以,现在很多网站,在设置URL时干脆只其做2层结构:首页和其他页面,他页面全部放在二级目录下,URL 规则www.cjzzc.com/wailian.html

•翻页规则:主要针对列表页,当翻页过万时,底部的翻页规则建议做成 间隔是50> 100,甚至更多,如底部规则可以做成“1,2,3,4,5,10,20,30, 40,50\”,以此类推,当蜘蛛爬到第五页时,底部显示就变成了 “6,7,8,9,15, 25,35,45,55”,这样蜘蛛顺着爬,可以很快将所有翻页爬完。

•伪静态/绝对地址:蜘蛛喜欢伪静态/绝对地址,动态参数不要太多、太复杂,目前百度对动态URL己经有了很好的处理,但是参数过多、过复杂的URL,有可能被蜘蛛认为不重要而抛弃;不要添加蜘蛛难以解析的字符。

•蜘蛛陷阱:302跳转>flash跳转、flash页面>session id、强制性使用cookies、要求登录填写验证码等。

•屏蔽蜘蛛:Disallow: /

•网站地图:xml网站地图,向百度提交最新sitemap

•大量弹窗和低质量广告页面。

六、蜘蛛入口

有些网站每天都能保持一定数量的原创文章更新,xml网站地图或者服务器日志显示每天蜘蛛来的时间很短,或者期待新增的专题页/文章页能够在搜索引擎有很好的排名,那么,在首页增加入口是最好的办法。

虽然xml网站地图会让网页收录,但收录和能在搜索引擎用site命令检索到是两回事,检索到了能够有排名又是另一回事。一个网站,因为所有页面都投票给首页,所以首页的权重最高,首页给了入口,等于网站权重最高的页面给“入口页”进行投票,入口页的权重就瞬间提高;

此外,蜘蛛一般从首页往其他层级页面爬行,首页给入口,意味着只要蜘蛛访问网站,入口页就会被爬到收录。

七、代码优化

蜘蛛给每一个网站,在一个时间阶段内的时间、蜘蛛数量是大致固定的。

同样的时间,爬一个1万行代码的网页,相当于爬10个1000行代码的网页。所以,从理论上讲,如果你现有的网页代码是1万行,你能缩减到1000行以内,那么,同等的权重,蜘蛛抓取的网站应该可以提升10倍。

页面数量几万以内,代码优化的效果体现很慢,对于百万、千万级别的网站而言,代码优化的效果,不管是搜索引擎收录量还是新增UV,都会起到不可思议的效果。

蜘蛛访问网站的时间是有限的,如果蜘蛛抓取一个页面需要正常速度的三五倍,甚至十倍,那么能抓取的页面肯定是有限的。网站服务器还有一个最大的问题是用户体验很差,对于今天“用户体验至上”的搜索引擎来说,不仅抓取受影响,而且排名会直线下跌。

康维主机测评-网站SEO优化

康维主机测评-网站SEO优化